Hadoop配置使用Solr

Solr可以和Hadoop一起使用。 由於Hadoop是用於處理大量數據,Solr幫助我們從這麼大數據源中找到所需的信息。在本節中,我們將瞭解如何在系統上安裝Hadoop。

下載Hadoop

下面給出瞭如何將Hadoop下載到系統中的步驟。

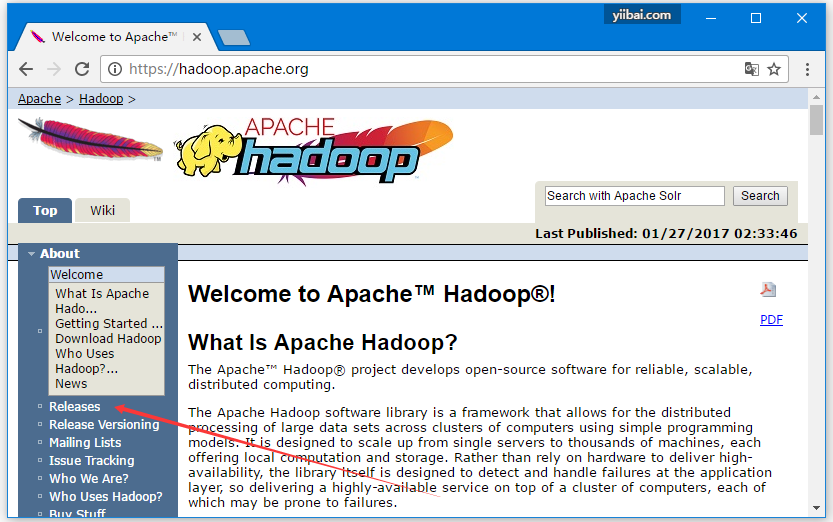

第1步 - 打開Hadoop主頁 - www.hadoop.apache.org/。 單擊鏈接版本,如下面的屏幕截圖中突出顯示。

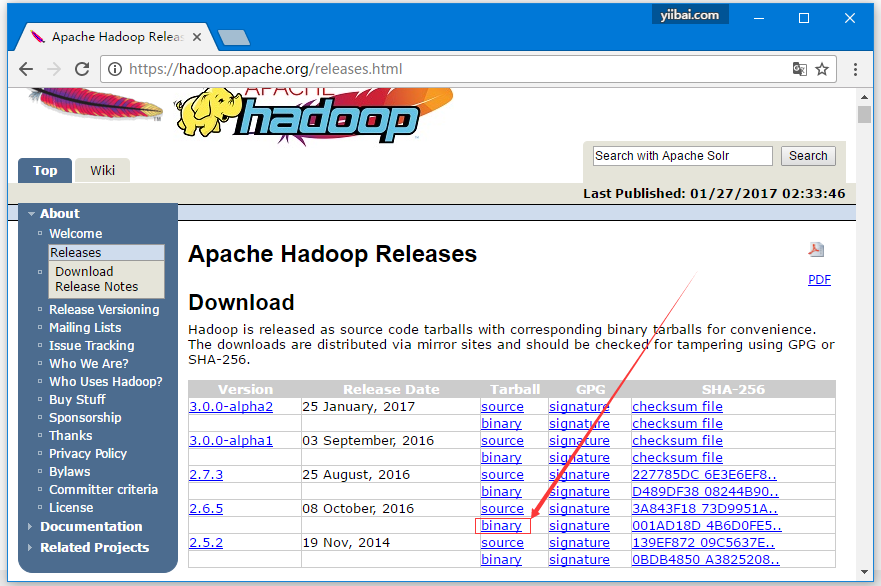

它將重定向到Apache Hadoop發佈頁面,其中包含有關各種版本的Hadoop源代碼和二進制文件鏡像的鏈接,如下所示:

步驟2 - 選擇最新穩定Hadoop版本(在本教程中,選擇的是2.6.4),並單擊其二進制鏈接。 它將轉到一個頁面,其中提供了Hadoop二進制文件的鏡像。單擊其中一個鏡像下載Hadoop。

從命令提示符下載Hadoop

打開Linux終端並以超級用戶(root)身份登錄。

$ su

password:轉到需要安裝Hadoop的目錄,並使用之前複製的鏈接將文件保存在此目錄下,如下面的代碼塊所示。

# cd /usr/local

# wget http://redrockdigimark.com/apachemirror/hadoop/common/hadoop-

2.6.4/hadoop-2.6.4.tar.gz下載Hadoop後,使用以下命令解壓縮。

# tar zxvf hadoop-2.6.4.tar.gz

# mkdir hadoop

# mv hadoop-2.6.4/* to hadoop/

# exit安裝Hadoop

按照下面給出的步驟在僞分佈式模式下安裝Hadoop。

第1步:設置Hadoop

可以通過將以下命令附加到〜/ .bashrc文件來設置Hadoop環境變量。

export HADOOP_HOME = /usr/local/hadoop export

HADOOP_MAPRED_HOME = $HADOOP_HOME export

HADOOP_COMMON_HOME = $HADOOP_HOME export

HADOOP_HDFS_HOME = $HADOOP_HOME export

YARN_HOME = $HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR = $HADOOP_HOME/lib/native

export PATH = $PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

export HADOOP_INSTALL = $HADOOP_HOME接下來,將所有更改應用到當前運行的系統,執行以下代碼 -

$ source ~/.bashrc第2步:Hadoop配置

可以在位置「$HADOOP_HOME/etc/hadoop」目錄中找到所有Hadoop配置文件。需要根據您的Hadoop基礎結構對這些配置文件進行更改。

$ cd $HADOOP_HOME/etc/hadoop爲了在Java中開發Hadoop程序,必須通過將JAVA_HOME值替換爲系統中Java的位置來重置hadoop-env.sh文件中的Java環境變量。

export JAVA_HOME = /usr/local/jdk1.7.0_71以下是必須編輯以配置Hadoop的文件的列表 -

- core-site.xml

- hdfs-site.xml

- yarn-site.xml

- mapred-site.xml

core-site.xml

core-site.xml文件包含諸如用於Hadoop實例的端口號,爲文件系統分配的內存,用於存儲數據的內存限制以及讀/寫緩衝區大小的信息。

打開core-site.xml並在<configuration>,</ configuration>標籤中添加以下屬性。

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>hdfs-site.xml

hdfs-site.xml文件包含本地文件系統的複製數據值,namenode路徑和datanode路徑等信息。表示要存儲Hadoop基礎架構的位置。

假設有以下數據。

dfs.replication (data replication value) = 1

(In the below given path /hadoop/ is the user name.

hadoopinfra/hdfs/namenode is the directory created by hdfs file system.)

namenode path = //home/hadoop/hadoopinfra/hdfs/namenode

(hadoopinfra/hdfs/datanode is the directory created by hdfs file system.)

datanode path = //home/hadoop/hadoopinfra/hdfs/datanode打開此文件,並在<configuration>,</ configuration>標記中添加以下屬性。

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.name.dir</name>

<value>file:///home/hadoop/hadoopinfra/hdfs/namenode</value>

</property>

<property>

<name>dfs.data.dir</name>

<value>file:///home/hadoop/hadoopinfra/hdfs/datanode</value>

</property>

</configuration>注意 - 在上述文件中,所有屬性值都是用戶定義的,您可以根據Hadoop基礎結構進行更改。

yarn-site.xml

此文件用於在Hadoop中配置yarn 。 打開yarn-site.xml文件,並在此文件中的<configuration>,</ configuration>標記之間添加以下屬性。

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>mapred-site.xml

此文件用於指定使用的MapReduce框架。默認情況下,Hadoop包含yarn-site.xml模板。 首先,需要使用以下命令將文件從mapred-site,xml.template複製到mapred-site.xml文件。

$ cp mapred-site.xml.template mapred-site.xml打開mapred-site.xml文件,並在<configuration>,</ configuration>標籤中添加以下屬性。

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>驗證Hadoop安裝

以下步驟用於驗證Hadoop安裝。

第1步:命名節點設置

使用命令「hdfs namenode -format」設置namenode,如下所示。

$ cd ~

$ hdfs namenode -format預期輸出結果如下 -

10/24/14 21:30:55 INFO namenode.NameNode: STARTUP_MSG:

/************************************************************

STARTUP_MSG: Starting NameNode

STARTUP_MSG: host = localhost/192.168.1.11

STARTUP_MSG: args = [-format] STARTUP_MSG: version = 2.6.4

...

...

10/24/14 21:30:56 INFO common.Storage: Storage directory

/home/hadoop/hadoopinfra/hdfs/namenode has been successfully formatted.

10/24/14 21:30:56 INFO namenode.NNStorageRetentionManager: Going to retain 1

images with txid >= 0

10/24/14 21:30:56 INFO util.ExitUtil: Exiting with status 0

10/24/14 21:30:56 INFO namenode.NameNode: SHUTDOWN_MSG:

/************************************************************

SHUTDOWN_MSG: Shutting down NameNode at localhost/192.168.1.11

************************************************************/第2步:驗證Hadoop dfs

以下命令用於啓動Hadoop dfs。執行此命令將啓動Hadoop文件系統。

$ start-dfs.sh輸出結果如下 -

10/24/14 21:37:56

Starting namenodes on [localhost]

localhost: starting namenode, logging to /home/hadoop/hadoop-2.6.4/logs/hadoop-

hadoop-namenode-localhost.out

localhost: starting datanode, logging to /home/hadoop/hadoop-2.6.4/logs/hadoop-

hadoop-datanode-localhost.out

Starting secondary namenodes [0.0.0.0]第3步:驗證Yarn腳本

以下命令用於啓動Yarn腳本。執行此命令將啓動 Yarn 實例。

$ start-yarn.sh輸出結果如下 -

starting yarn daemons

starting resourcemanager, logging to /home/hadoop/hadoop-2.6.4/logs/yarn-

hadoop-resourcemanager-localhost.out

localhost: starting nodemanager, logging to /home/hadoop/hadoop-

2.6.4/logs/yarn-hadoop-nodemanager-localhost.out第4步:在瀏覽器上訪問Hadoop

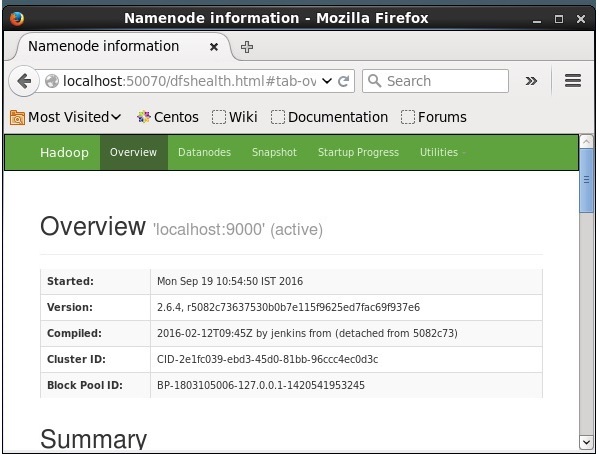

訪問Hadoop的默認端口號爲50070。使用以下URL在瀏覽器上獲取Hadoop服務。

得到結果如下 -

在Hadoop上安裝Solr

按照以下步驟下載並安裝Solr。

第1步

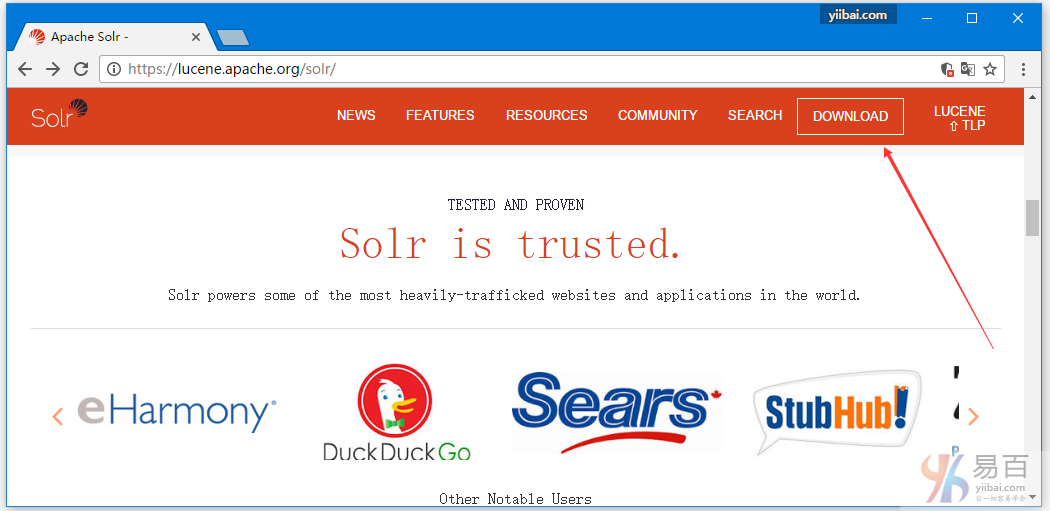

通過單擊以下鏈接打開Apache Solr的主頁 - http://lucene.apache.org/solr/

第2步

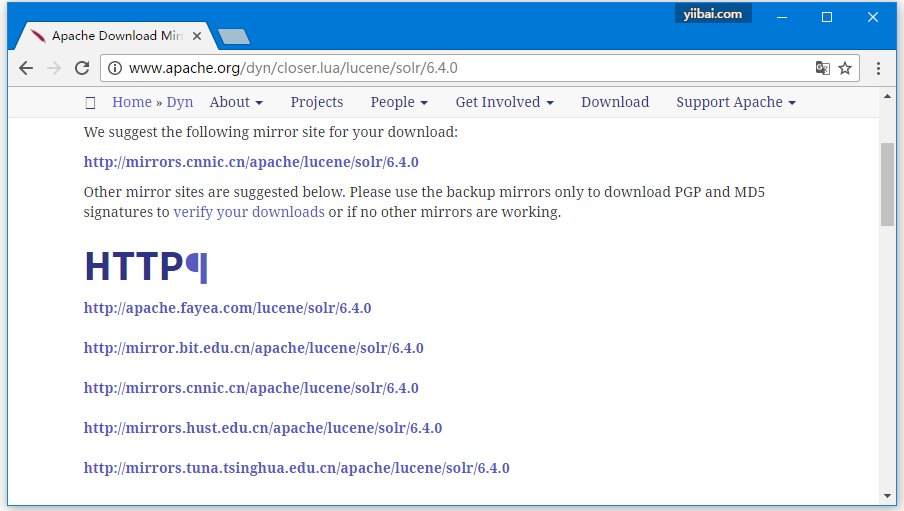

點擊下載按鈕(在上面的截圖中箭頭突出顯示)。點擊後將被重定向到Apache Solr的各種鏡像的頁面。 選擇一個鏡像並單擊它,這將重定向到一個頁面,您可以下載Apache Solr的源文件和二進制文件,如下面的屏幕截圖所示。

第3步

選擇Solr-6.2.0.tqz的文件夾將它下載到系統的文件夾中。提取下載的文件夾的內容。

第4步

在Hadoop主目錄中創建一個Solr的文件夾,並將解壓縮文件夾的內容移動到其中,如下所示。

$ mkdir Solr

$ cd Downloads

$ mv Solr-6.2.0 /home/Hadoop/驗證

進入到solr主目錄的bin文件夾,並使用version選項驗證安裝,如以下代碼塊所示。

$ cd bin/

$ ./Solr version

6.2.0設置主目錄和路徑

使用以下命令打開.bashrc文件 -

[Hadoop@localhost ~]$ source ~/.bashrc現在設置Apache Solr的home和path目錄如下 -

export SOLR_HOME = /home/Hadoop/Solr

export PATH = $PATH:/$SOLR_HOME/bin/打開終端並執行以下命令 -

[Hadoop@localhost Solr]$ source ~/.bashrc現在,可以從任何目錄執行Solr命令。